Importance de définir une stratégie de récupération de grandes données

Les données massives forment essentiellement un large ensemble de données qui, une fois analysées, révèlent de nouveaux modèles ou tendances qui aident à déterminer le comportement, les préférences et les interactions humaines. Les organismes publics utilisent les données massives pour mieux cerner les besoins de la population, et élaborer des plans d’amélioration communautaire. Un bon nombre d’entreprises s’appuient sur les données massives pour comprendre le comportement des consommateurs, et prévoir les tendances futures du marché. Les données massives sont également utiles aux particuliers, car l’information sur la réaction des gens aux produits et services qui leur sont offerts, peut à son tour être utilisée par les consommateurs pour prendre des décisions quant aux achats à faire et ceux à éviter.

Protection des données de l’entreprise

Alors que le paysage numérique mondial continue de s’étendre et d’évoluer, notre capacité à sécuriser de manière efficace et efficiente les données massives, devient de plus en plus importante. Dans le monde de l’entreprise en particulier, ces ensembles de données sont essentiels pour s’assurer que les objectifs sont atteints et que les entreprises progressent dans la bonne direction. Sans cette information, il serait beaucoup plus difficile pour les entreprises de faire du marketing auprès de l’auditoire approprié. Les données massives deviennent exponentiellement plus pertinentes, la perte de ces données est synonyme de perte d’informations potentiellement précieuses, ce qui pourrait se traduire par des pertes financières importantes et une perte de temps et de ressources.

Pour poursuivre leur croissance, les entreprises doivent s’assurer que leurs bases de données sont sauvegardées et qu’elles peuvent être restaurées en cas de catastrophe. Pour poursuivre leur croissance, les entreprises doivent s’assurer que leurs bases de données sont sauvegardées et qu’elles peuvent être restaurées en cas de catastrophe. Compte tenu de l’énorme quantité d’informations importantes en jeu, il est extrêmement judicieux de prévenir la perte de données grâce à une stratégie de récupération. Préalablement à la création d’un plan de restauration efficace, les entreprises doivent d’abord déterminer les processus permettant d’éviter des pertes de données, les solutions palliatives de récupération rapide et la visibilité constante.

Prévention des pertes de données

Pour réduire au minimum les risques de perte d’informations importantes, un élément clé de la sécurisation des données est la définition et la communication de procédures visant à prévenir les situations de perte de données en premier lieu. Une des solutions consiste simplement à limiter l’accès des utilisateurs qui n’ont pas besoin des données massives pour accomplir leurs tâches. Le fait de minimiser l’accès et de garder une trace des employés qui y ont accès, réduira le risque opérationnel, que des personnes effacent accidentellement les données ou en abusent.

Limiter les temps d’arrêt

Trouver une solution haute vitesse qui limite les temps d’arrêt est également crucial pour assurer le succès d’une stratégie de reprise. Par exemple, il serait très utile de définir un point de récupération en fonction d’un objectif de temps (RPO). Le temps RPO est la durée maximale pendant laquelle un ensemble de données peut être débranché après une panne ou un sinistre avant que la perte ne commence à se produire. Cette information permettra aux employés autorisés de travailler le plus rapidement possible en cas de panne pour restaurer les données. Les temps RPO peuvent varier en fonction de la taille des ensembles de données. Il faut garder à l’esprit que peu importe qu’une entreprise traite de grands ou de petits ensembles de données, il est toujours utile de déterminer un temps de RPO. Indépendamment de la taille, le but ultime est d’essayer de réduire le temps d’arrêt de vos données et de trouver le moyen le plus efficace de restaurer votre ensemble de données spécifique.

Tests programmés et restauration

Une autre façon de rassurer les consommateurs et les employés en matière de sécurité est de décider de la fréquence des tests/restaurations. Programmer un échéancier semestriel et/ou bimensuel de tests/restauration permet de s’assurer que les ensembles de données sont correctement mis à jour et adéquatement protégés. Plus important encore, les périodicités des tests devraient servir à indiquer si le temps de RPO décidé est précis ou non. Ces tests pourraient indiquer qu’en cas de sinistre ou d’accident éventuel, la charge du travail consacrée aux données massives d’une entreprise, aurait une chance de survivre.

Connaître vos données

Comme il y a une variété d`environnements de données massives, les stratégies de récupération sont parfois complexes et de grande ampleur. Beaucoup d`entreprises exploitent et analysent des ensembles particuliers de données de différentes façons. La connaissance du type d’ensemble de données que vous traitez et sa taille estimée contribuera à l’élaboration d’une stratégie de récupération efficace. Il est également important de noter qu’une solide stratégie de récupération requiert que les données aient une visibilité constante. Savoir où chaque ensemble de données est stocké, comment y accéder et en conserver des instantanés, peut apporter une solution simple et efficace en cas de panne ou de sinistre. Par exemple, une réplication d’un onduleur en direct signifie avoir une prise secondaire en cas d’accident, garantissant que les données sont toujours enregistrées sur une deuxième source.

Au moment de la réalisation des réplications, il est crucial qu’un professionnel certifié soit présent ou que des personnes formées soient impliquées dans le processus. Même si la réplication en direct s’avère une solution attrayante, car elle garantit un transfert fluide de données entre les périphériques, une réplication en direct mal conçue risque de faire perdre des données. Par conséquent, les personnes impliquées dans la réalisation de la réplication en direct doivent être conscientes et bien informées sur le sujet et sur le processus.

Protégez vos données

Notre monde devient de plus en plus perspicace technologiquement, et les entreprises continueront de dépendre fortement des données massives pour prédire les tendances futures, analyser les tendances actuelles et déterminer les nouvelles caractéristiques des consommateurs. En veillant à ce que les ensembles de données soient constamment restaurés et sauvegardés, les organisations peuvent continuer à prospérer et à améliorer leurs services. Différentes solutions sont envisageables pour garantir une stratégie de récupération efficace et efficiente. Chaque entreprise est unique lorsqu’il est question de données et de la façon dont elle décide d’analyser ses propres ensembles de données, mais une chose que toutes les entreprises sont censées se partager est la définition d’un plan pour élaborer, instaurer et améliorer leur stratégie de récupération des données.

L’avenir du Big Data (mégadonnées)

Les données (data) sont un ensemble de faits et de statistiques utilisés à des fins de référence ou d’analyse. Les entreprises recueillent, mesurent, communiquent et analysent des données pour mieux comprendre les clients, les produits, les compétences et les clients.

Le Big Data (mégadonnées) est l’analyse de grands ensembles de données qui révèlent certains modèles, tendances et associations liés au comportement humain et aux interactions commerciales. Dans le monde d’aujourd’hui, l’information est continuellement recueillie, c’est pour cette raison que l’analyse des mégadonnées est devenue le point de mire de l’industrie des technologies de l’information (TI).

Glassdoor, l’un des sites de recrutement d’emplois qui connaît la croissance la plus rapide au Canada, a publié un rapport en 2017 qui distingue les 50 emplois les plus recherchés. Il a déterminé que le score global des analystes de données était de 4,8 sur 5, avec un score de satisfaction professionnelle de 4,4 sur 5 et un salaire de base moyen de 110 000 $.

Pourquoi le Big Data est-il si populaire sur le marché du travail ? Parce que les mégadonnées seront toujours nécessaires dans le monde technologique dans lequel nous vivons.

Le monde en évolution du Big Data

Selon Bernard Marr, dans son article « 17 Predictions about the Future of Big Data Everyone Should Read », le Big Data a pris le dessus dans le monde des affaires. Les données ne cessent de croître et de se développer, et elles ne s’arrêteront jamais.

De nouvelles informations continueront toujours à voir le jour. Voici quelques-unes des principales prédictions formulées par les experts de l’industrie que Marr croit que tout analyste du big data devrait garder à l’esprit.

On s’attend à ce que de nouveaux appareils dotés de la technologie d’Intelligence Artificiel fassent leur apparition à l’avenir, y compris des robots, des véhicules autonomes, des assistants virtuels et des conseillers intelligents.

On s’attend à ce que le marché de l’emploi dans le secteur du big data croisse encore plus, et il n’y aura pas assez de personnes pour combler tous les postes que les entreprises doivent combler. Certaines entreprises devront se tourner vers elles-mêmes et former son propre personnel à l’analyse de big data pour combler ces postes.

Une autre réaction à la pénurie d’analystes de données consistera en l’augmentation de l’utilisation de l’informatique cognitive qui permet aux modèles informatisés d’imiter la façon dont les humains pensent et réagissent à l’information.

De nouveaux outils d’analyse plus intuitifs apparaîtront sur le marché et certains de ces outils permettront aux non-analystes d’accéder aux données. De plus, les experts pensent qu’en fin de compte, les meilleurs programmes seront ceux qui permettent aux utilisateurs d’utiliser les données pour prendre des décisions en temps réel.

Simultanément, plus d’entreprises envisageront à acheter des algorithmes plutôt que de tenter de les programmer. Attendez-vous à ce que les marchés des algorithmes augmentent.

La protection de la vie privée est et continuera d’être un énorme problème auquel est confronté le big data. Le public devrait s’attendre à voir plus de violations de l’éthique liées aux données.

Plus d’entreprises essaieront d’utiliser des données importantes pour augmenter leurs revenus.

Plus d’entreprises vendront non seulement des données, mais aussi des informations prêtes à l’emploi.

Les mégadonnées, en raison de leur volume, peuvent devenir trop lourdes. Plusieurs entreprises ne trouvent aucune utilité dans toutes les données recueillies. Un jour, des « données rapides » et des « données exploitables » avec des utilitaires spécifiques pourront remplacer le big data.

L’avenir du big data

Imaginez qu’il existe un ordinateur capable de modifier les constructions sociales et économiques de notre société ; un ordinateur comme celui-là pourrait évoluer à terme et modeler la société à son goût.

La théorie à propos de cet ordinateur omnipotent s’appelle le Graphe Universel.

En mathématiques, un Graphe Universel est un graphe infini qui contient tous les graphes finis comme sous-graphes. En termes plus simples, il s’agit d’un graphe ou d’un réseau dans lequel un seul élément d’information peut être relié à d’autres éléments d’information jusqu’à ce que tous les éléments d’information finis soient intégrés dans un seul graphique. On peut imaginer le Graphe Universel comme étant un ordinateur qui contient toutes les informations du monde – une sorte de « superordinateur ».

Non seulement la théorie d’un Graphe Universel existe, mais la technologie nécessaire existe déjà dans les formes déconnectées du big data des grandes entreprises comme Netflix, Google, Facebook et autres.

Le Graphe Universel est conçu pour prendre l’information que toutes ces entités possèdent et la mettre ensemble dans une réalité informatique alternative de notre monde. Cette réalité alternative est ensuite soumise à des formules qui sont capables de déterminer des modèles à grande échelle dans le monde entier. C’est semblable à la façon dont les grandes entreprises recueillent et analysent les données aujourd’hui, mais à une échelle universelle.

Le Graphe Universel

Alors, qu’est-ce que ce superordinateur comprendra exactement ? Les possibilités sont infinies.

Un Graphe Universel pourrait techniquement contenir des informations sur tout et n’importe quoi : l’ensemble des gènes d’un animal, une particule, un livre, une entreprise, voire même une personne entière. Le Graphe Universel verrouille ces points de données avec le reste des données. Par exemple, le Graphe Universel pourrait mettre en œuvre l’information d’un manuel scolaire dans un gène spécifique et raccorder ce gène dans un être humain qui porterait alors un gène qui lui permettrait de tout savoir dans le contenu du manuel susmentionné.

Un Graphe Universel peut ressembler à un concept fantastique de science-fiction qui peut devenir une réalité dans un avenir proche.

En ce moment-même, de grandes entreprises recueillent déjà des données à votre sujet en tant qu’individu. Ils connaissent votre date de naissance, vos relevés de notes d’études collégiales ou secondaires, vos habitudes de shopping, vos messages sur les médias sociaux et même ce que vous mangez.

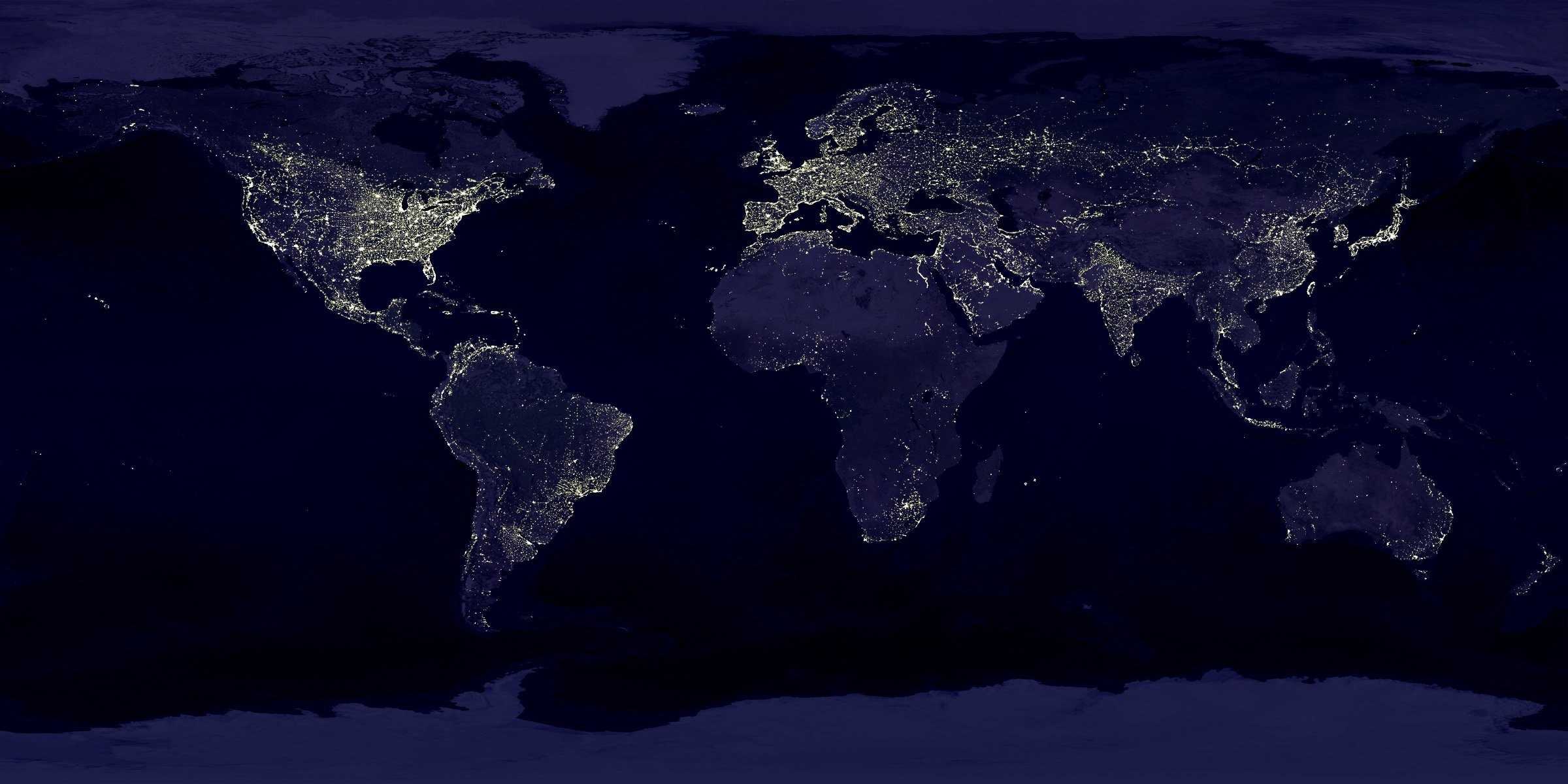

C’est un monde d’information

Le monde se rapproche et se connecte de plus en plus à mesure que la technologie progresse, ce qui peut être une bonne et une mauvaise chose. Ce que l’on sait c’est que le big data est là pour rester, et quelque chose comme le Graphe Universel, qui aurait pu sembler tiré par les cheveux il y a 20 ans, est maintenant devenu un concept très plausible que nous pourrions bientôt voir. Mais l’avenir reste incertain. Le monde technologique dans lequel nous vivons est plein de surprises. Attendons de voir ce que l’avenir du big data nous réserve.